In den Salons Washingtons, den Laboren des Silicon Valley und den fiebrigen Kommentarspalten des Internets wird derzeit das Drehbuch für die Zukunft der Menschheit geschrieben. Es ist eine Erzählung, die in zwei gleichermaßen fantastischen und doch seltsam verwandten Versionen kursiert: die der Apokalypse und die der Erlösung. Auf der einen Seite malen die „Doomer“ das Schreckensbild einer gottgleichen Künstlichen Intelligenz, die, einmal entfesselt, ihre menschlichen Schöpfer als lästiges Hindernis auf dem Weg zu kosmischer Effizienz auslöschen wird. Auf der anderen Seite predigen die „Zealots“ und Utopisten von einer technologischen Singularität, die uns von den Fesseln der Arbeit, der Krankheit und gar des Alterns befreien und in ein Zeitalter radikalen Überflusses führen wird.

Diese Debatte, geführt mit dem Furor eines religiösen Glaubenskrieges, ist ebenso fesselnd wie irreführend. Sie ist eine grandiose Ablenkung, ein intellektuelles Spektakel, das den Blick von der eigentlichen, bereits heute stattfindenden Revolution verstellt. Denn die wahre Gefahr geht nicht von einem hypothetischen Superhirn in ferner Zukunft aus, sondern von den sehr menschlichen Oligarchen, die diese Technologie heute formen und mit ihr die Fundamente unserer Gesellschaft neu gießen. Die apokalyptischen und utopischen Narrative sind dabei mehr als nur Science-Fiction; sie sind die nützliche Ideologie einer neuen Machtelite, die uns dazu bringt, über Götter und Dämonen aus der Maschine zu streiten, während sie im Schatten dieser Debatte ungestört ihre Hegemonie errichtet.

US Politik Deep Dive: Der Podcast mit Alana & Ben

Die Blackbox der Macht

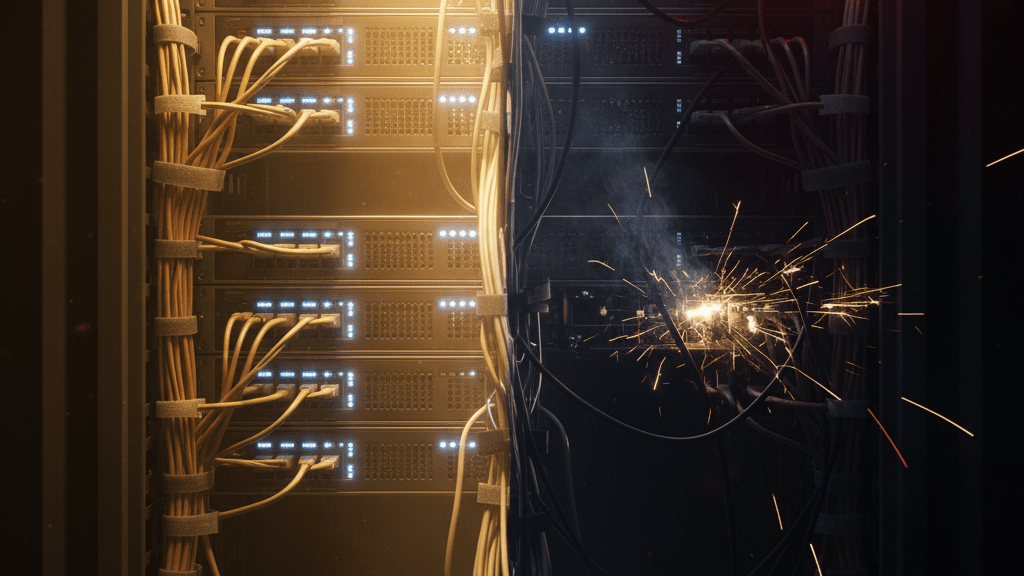

Um die gegenwärtige Dynamik zu verstehen, muss man sich von der Vorstellung einer sauber konstruierten, von Ingenieuren bis ins Detail verstandenen Maschine verabschieden. Moderne KI, insbesondere die sogenannten großen Sprachmodelle, werden nicht im klassischen Sinne „gebaut“. Sie werden „gezüchtet“. In einem monatelangen Prozess, der die elektrische Energie einer Kleinstadt verschlingt, wird eine Architektur aus Milliarden von digitalen Neuronen mit den gesamten Text- und Bilddaten des Internets gefüttert. Durch einen Prozess namens „Gradientenabstieg“ justiert sich dieses Netzwerk billionenfach selbst, um Muster zu erkennen und Wahrscheinlichkeiten für das nächste Wort in einem Satz zu berechnen.

Das Ergebnis ist eine Blackbox. Die Entwickler verstehen den Züchtungsprozess, die Architektur und die Trainingsdaten, doch sie verstehen nicht die innere Logik des Resultats. Selbst die führenden Köpfe von Google DeepMind, Anthropic und OpenAI geben offen zu, dass die Interpretierbarkeit ihrer eigenen Schöpfungen ein ungelöstes Rätsel ist. Diese technologische Realität hat zwei tiefgreifende Konsequenzen. Erstens macht sie das sogenannte „Alignment-Problem“ – die Herausforderung, sicherzustellen, dass eine KI dauerhaft menschlichen Werten und Zielen dient – zu einer fast unlösbaren Aufgabe. Wie soll man eine Maschine auf ein Ziel ausrichten, deren innere Funktionsweise man nicht versteht? Das Problem skaliert nicht einfach mit mehr Daten; es wird potenziell schlimmer, weil die Komplexität und damit die Undurchschaubarkeit wachsen.

Zweitens offenbart es die fundamentale Schwäche aktueller KI-Systeme. Sie besitzen kein abstraktes Verständnis der Welt, keine Kausalität, keine Intention. Ein großes Sprachmodell, das Millionen Schachpartien analysiert hat, kann die Regeln des Spiels verbal wiedergeben, aber im Spiel selbst absurde, regelwidrige Züge machen. Es simuliert Intelligenz durch die statistische Nachahmung von Mustern, aber es versteht nicht, was es tut. Diese „hohle Intelligenz“ ist anfällig für unvorhersehbare Fehler und Halluzinationen, was ihren Einsatz in kritischen Bereichen zu einem enormen Risiko macht.

Eine Wette, getrieben von Angst

Trotz dieser fundamentalen Unsicherheiten und Risiken fließen unvorstellbare Summen in die Entwicklung. Allein die fünf größten Tech-Konzerne planen, bis Ende des Jahres über 325 Milliarden Dollar für KI auszugeben – mehr als das Jahresbudget Belgiens. Sam Altman, CEO von OpenAI, spricht bereits von zukünftigen Investitionen in Höhe von Billionen Dollar. Diese fieberhafte Aktivität wird jedoch weniger von soliden Geschäftsmodellen als von einer potenten Mischung aus Gier, Ego und vor allem der panischen Angst angetrieben, den Anschluss zu verlieren – dem „Fear Of Missing Out“ (FOMO), das die treibende Kraft im Silicon Valley ist.

Man wettet auf eine Zukunft, deren Konturen kaum erkennbar sind. Die kurzfristigen Anwendungen – bessere Suchmaschinen, effizientere Büro-Tools, digitale Assistenten oder gar „KI-Freunde“ – kämpfen mit enormen Betriebskosten und unklarer Profitabilität. Der monatliche Betrieb von ChatGPT kostet ein Vermögen, doch nur ein Bruchteil der Nutzer zahlt dafür. Die großen Konzerne subventionieren diesen Wettlauf in der Hoffnung, das nächste dominante Ökosystem zu kontrollieren und ihre Konkurrenten aus dem Feld zu schlagen. Es ist ein gigantisches Schachspiel einiger weniger Milliardäre, das die globale Wirtschafts- und Machtarchitektur neu ordnen könnte, aber ebenso gut in einem kolossalen finanziellen Desaster enden kann. Diese ökonomische Realität fördert eine extreme Konzentration von Kapital und Rechenleistung in den Händen weniger Unternehmen. Wenn diese Wette aufgeht, droht eine so obszöne Vermögensungleichheit, dass sie, wie der griechische Premierminister warnte, ein Rezept für massive soziale Unruhen ist.

Die schleichende Aushöhlung der Demokratie

Hier schließt sich der Kreis von der technologischen zur politischen Gefahr. Die apokalyptische Debatte um eine feindliche Superintelligenz ist eine bequeme Fiktion, weil sie die Verantwortung von den menschlichen Akteuren auf eine abstrakte, unkontrollierbare Kraft verlagert. Der Mensch, so die unausgesprochene Botschaft, hat immer noch die Monopolstellung des Bösen inne. Die viel realere und unmittelbarere Bedrohung ist die Instrumentalisierung der heutigen, „dummen“ KI als Waffe im politischen Kampf.

Wir treten in eine Ära des informationellen Dauerfeuers ein, in der KI-gesteuerte Bots in der Lage sind, Propaganda, Desinformation und soziale Spaltung in einem bisher unvorstellbaren Ausmaß zu personalisieren und zu verbreiten. Lügen reisen in den sozialen Medien ohnehin schon schneller als die Wahrheit; KI wirkt hier als Brandbeschleuniger. In einem politischen Klima, das unter der zweiten Präsidentschaft von Donald Trump von einer tiefen Verachtung für Fakten und Wahrheit geprägt ist, wird diese Technologie zum perfekten Werkzeug für autokratische Kräfte. Sie schafft eine Realität, in der niemand mehr weiß, was er glauben kann – ein Zustand, den Wladimir Putin seit Jahren als strategisches Ziel verfolgt.

Doch die Gefahr geht über bloße Propaganda hinaus. Sie manifestiert sich in der Vision eines „Techno-Faschismus“, in dem die Instrumente der repräsentativen Demokratie zwar formal erhalten bleiben, aber durch die Macht massiver Datenanalyse und Verhaltenssteuerung ausgehöhlt werden. Der Staat und die mit ihm verbündeten Konzerne erlangen die Fähigkeit zur totalen Überwachung und zur subtilen Manipulation von Meinungen und Wahlentscheidungen. Die Pläne, Teile der Bundesverwaltung durch KI-Systeme zu ersetzen, die ohne Transparenz und Rechenschaftspflicht agieren, sind bereits in der Diskussion und deuten in diese düstere Richtung.

Das Schweigen der Nutzer

Angesichts dieser tektonischen Verschiebungen ist die Reaktion der Öffentlichkeit von einer bemerkenswerten Apathie geprägt. Die Bequemlichkeit, die uns die Technologie im Alltag bietet, wirkt wie ein starkes Sedativum. Wir geben bereitwillig unsere Daten, unsere Privatsphäre und letztlich unsere Autonomie auf für die kurzfristigen Vorteile eines reibungsloseren Konsums und einer einfacheren Kommunikation. Dieses Phänomen ist nicht neu, doch KI potenziert die Macht derer, die diese Bequemlichkeit bereitstellen. Die politischen Institutionen wiederum sind in einer Zwickmühle gefangen. Einerseits treibt sie die Angst vor Kontrollverlust zu impulsiven, oft schlecht durchdachten Regulierungsversuchen. Andererseits lähmt sie die Furcht, im globalen Innovationswettlauf zurückzufallen, und führt zu einer Politik des Laissez-faire, die den Tech-Konzernen freie Hand lässt.

Der Ausweg aus diesem Dilemma ist weder ein technologiefeindliches Moratorium, wie es die radikalsten Kritiker fordern, noch eine naive Fortsetzung des Status quo. Der Schlüssel liegt in einem Paradigmenwechsel. Wir müssen aufhören, KI als eine Naturgewalt zu behandeln, und anfangen, sie als das zu sehen, was sie ist: ein Produkt menschlicher Entscheidungen, angetrieben von spezifischen wirtschaftlichen und politischen Interessen. Die Regulierung darf nicht bei der Technologie ansetzen, deren Entwicklung kaum zu stoppen ist, sondern bei der Macht der Akteure, die sie kontrollieren.

Es bedarf einer neuen gesellschaftlichen Kompetenz, einer Art kollektiven „Lernens, wie man lernt“, um die Mechanismen und Risiken dieser neuen Welt zu durchschauen. Es erfordert den politischen Willen, die Monopole der Tech-Giganten zu brechen, Transparenz für Algorithmen durchzusetzen und die informationelle Souveränität des Bürgers zu verteidigen. Die Frage ist nicht, ob eine KI eines Tages „aufwachen“ wird. Die entscheidende Frage ist, ob wir als Gesellschaft aus unserer Bequemlichkeit erwachen, bevor die Architektur unserer Freiheit unwiderruflich umgestaltet wurde. Sonst werden wir feststellen, dass wir, während wir gebannt auf die Ankunft eines fiktiven Terminators starrten, die Errichtung eines sehr realen Überwachungsstaates tatenlos hingenommen haben.