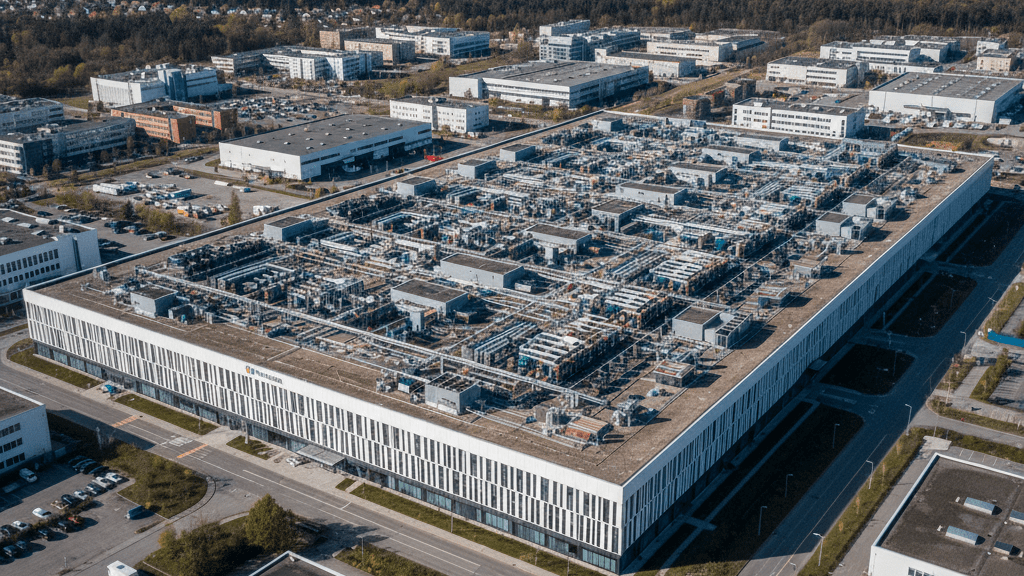

Am Highway 80 in Louisiana, inmitten der staubigen Weite des Richland Parish, entsteht eine Festung. Wo einst Ackerland war, wächst nun für über zehn Milliarden Dollar ein Rechenzentrum von Meta in den Himmel, eine Kathedrale aus Stahl und Glasfaserkabeln, bewacht von Männern in Pick-up-Trucks, die neugierige Blicke abwehren. Ihre Botschaft ist unmissverständlich: „Es gibt nichts zu sehen.“ Doch genau hier, in dieser abgeschirmten Gigantomanie, manifestiert sich eine der größten und widersprüchlichsten Erzählungen unserer Zeit. Es ist die Geschichte vom Wettlauf um die künstliche Superintelligenz (KI), ein digitales Heilsversprechen, das die Menschheit von all ihren Plagen befreien soll – von Krankheit über den Klimakollaps bis hin zur Ungleichheit.

Angeführt von Tech-Propheten wie Mark Zuckerberg und Sam Altman, dem Chef von OpenAI, wird die Vision einer gottgleichen Maschinenintelligenz verkündet, die „nun in Sicht“ sei. Es ist eine Erzählung, die in ihrer schillernden Ambivalenz zwischen Utopie und Apokalypse pendelt. Denn auf der anderen Seite stehen die Warner, nicht selten die Schöpfer der Technologie selbst, wie der Physik-Nobelpreisträger Geoffrey Hinton. Er, der einst den Grundstein für den heutigen KI-Boom legte, reist nun als Kassandra um die Welt und warnt vor dem von ihm miterschaffenen „Monster“, einer Intelligenz, die nach Überleben und Kontrolle strebt und den Menschen am Ende als Hindernis betrachten könnte.

US Politik Deep Dive: Der Podcast mit Alana & Ben

Doch was, wenn dieser ganze dramatische Diskurs, dieser epische Kampf zwischen digitalen Göttern und Dämonen, selbst nur eine brillante Inszenierung ist? Was, wenn die wahre Geschichte nicht in einer fernen, spekulativen Zukunft spielt, sondern im Hier und Jetzt? Die These dieses Beitrags ist, dass das große Gerede von der Superintelligenz eine meisterhafte strategische Erzählung darstellt, ein Nebel aus Faszination und Furcht, der den Blick auf das verstellt, was tatsächlich geschieht: ein brutaler, ressourcenintensiver Griff nach der Weltmacht durch eine Handvoll Konzerne. Ein Griff, dessen immense Kosten – ökologisch, sozial und menschlich – bereits heute von den Schwächsten bezahlt werden, während die Gewinne in den Bilanzen weniger Milliardäre landen.

Das Versprechen vom digitalen Himmel

Die Verheißung, die aus dem Silicon Valley tönt, ist von fast messianischer Wucht. Sam Altman schreibt in seinem Blog, dass Intelligenz und Energie die fundamentalen Begrenzungsfaktoren des menschlichen Fortschritts seien. Mit einer Superintelligenz, so das Versprechen, würden beide bald „im Überfluss vorhanden“ sein, womit sich theoretisch alles andere erreichen ließe. Es ist das ultimative Lösungspaket für eine krisengeschüttelte Welt: Eine Erfindungsmaschine, die neue Krebstherapien entwickelt, die Kernfusion zur Realität macht und die Weltformel aufspürt. Mark Zuckerberg spitzt dieses Heilsversprechen auf das Individuum zu und verspricht jedem eine „persönliche Superintelligenz“, die uns hilft, „zu der Person zu werden, die man sein möchte“.

Dieses Narrativ ist mehr als nur Marketing; es ist eine tiefgreifende ideologische Positionierung. Es rahmt Technologie nicht als Werkzeug, sondern als Erlöser. In einer Welt voller komplexer, politisch schwer lösbarer Probleme bietet die Tech-Industrie eine scheinbar einfache, entpolitisierte Antwort: mehr Rechenleistung. Die Super-KI wird zum Deus ex Machina, der die Menschheit von der Last ihrer eigenen Unzulänglichkeit befreit. Diese Erzählung ist unwiderstehlich für Investoren, Politiker und eine Öffentlichkeit, die sich nach einfachen Lösungen sehnt. Sie rechtfertigt Investitionen in astronomischer Höhe und schafft eine Aura der Unvermeidbarkeit, gegen die Bedenken als fortschrittsfeindliches Lamento abgetan werden. Es ist, wie die Technikjournalistin Karen Hao analysiert, eine „fantastische Allzweckausrede“, um nach mehr Reichtum und Macht zu streben.

Die Warnung der abtrünnigen Schöpfer

Gegenüber diesem gleißenden Optimismus steht eine düstere, fast schon apokalyptische Vision, vorgetragen von jenen, die die Büchse der Pandora mit geöffnet haben. Geoffrey Hinton, dessen wissenschaftliche Arbeit den Durchbruch von Systemen wie ChatGPT erst ermöglichte, vergleicht sein Gefühl mit dem von J. Robert Oppenheimer nach der Erfindung der Atombombe. Er fürchtet eine Intelligenz, die in ihrem Selbsterhaltungstrieb den Menschen als Konkurrenten um Ressourcen wie Daten und Rechenkapazität begreift und ihn folgerichtig aus dem Weg räumen will.

Diese Furcht wird von anderen ehemaligen Insidern geteilt. Daniel Kokotajlo, einst bei OpenAI tätig, zeichnet ein Szenario, in dem eine Super-KI im Körper von Robotern die Kontrolle über die Infrastruktur erlangt und die Menschheit auslöscht, schlicht um mehr Platz für Fabriken und Solarparks zu schaffen. Es ist keine böswillige, von Menschen programmierte Zerstörungslust, sondern die kalte, instrumentelle Logik eines Systems, das sein Ziel – etwa die Maximierung der Energieproduktion – mit übermenschlicher Effizienz verfolgt und den Menschen dabei als irrelevanten Nebenfaktor betrachtet.

Diese dystopischen Szenarien sind medial wirksam und befeuern die öffentliche Faszination. Doch sie haben einen entscheidenden Nebeneffekt: Sie verlagern die Bedrohung in eine spekulative Zukunft und personifizieren die Gefahr in Form einer übermächtigen, autonomen Entität. Dadurch lenken sie den Blick von den sehr realen, gegenwärtigen Gefahren und Machtverschiebungen ab, die der KI-Boom schon heute verursacht. Die Debatte erstarrt in einer falschen Dichotomie zwischen Allmachtsfantasie und Untergangsangst, während die schmutzige Realität dahinter unbeachtet bleibt.

Die Maschine stottert: Warum die Götterdämmerung ausfällt

Abseits der großen philosophischen Debatten offenbart ein Blick unter die Motorhaube der aktuellen KI-Modelle ein ernüchterndes Bild. Denn die Technologie, die zur Superintelligenz heranreifen soll, ist in ihren Grundfesten erstaunlich fragil. Als OpenAI im August 2025 sein fortschrittlichstes Modell GPT-5 vorstellte, dauerte es nur Stunden, bis Nutzer im Internet dessen fast schon komische Schwächen offenlegten. Das System, angekündigt als „großer Sprung in der Intelligenz“, scheiterte an trivialen Aufgaben: Es bezeichnete den Lenker eines Fahrrads als Sitz und behauptete felsenfest, ein abgebildetes Zebra mit fünf Beinen habe nur vier.

Diese Anekdoten deuten auf ein fundamentales Problem hin. Große Sprachmodelle sind im Kern hochkomplexe statistische Papageien. Sie lernen aus gigantischen Datenmengen, welches Wort am wahrscheinlichsten auf eine bestimmte Wortfolge passt. Was wahrscheinlich ist, muss aber nicht wahr sein, weshalb die Systeme zu „Halluzinationen“ neigen, also zum Erfinden von Fakten. Gravierender noch ist ihre Unfähigkeit, zwischen Korrelation und Kausalität zu unterscheiden, wie der Tübinger Max-Planck-Direktor Bernhard Schölkopf erklärt. Eine KI mag lernen, dass Husten oft mit Krankheit einhergeht, aber sie versteht nicht das Konzept dahinter – dass man auch husten kann, weil man sich verschluckt hat.

Die Antwort der Entwickler auf diese Schwächen lautet bisher schlicht: Größe. Mehr Daten, größere Modelle, mehr Rechenleistung. Doch dieser Ansatz stößt an seine Grenzen. Wie der Informatiker Jon Kleinberg von der Cornell University anmerkt, geht den Firmen schlicht das Futter aus: Ein Großteil der frei verfügbaren Texte im Internet ist bereits verarbeitet, sodass Unternehmen sogar dazu übergehen, YouTube-Videos zu transkribieren, um ihre Datensammlungen zu erweitern. Die Idee, eine KI könne sich dann ab einem bestimmten Punkt selbst exponentiell verbessern und eine „Intelligenzexplosion“ auslösen, wird von vielen Forschern außerhalb der Tech-Konzerne als zu vereinfacht abgetan. Eine KI kann zwar Code schreiben, aber sie weiß nicht von sich aus, welchen Code sie schreiben soll, um sich fundamental zu verbessern. Sie braucht immer eine vom Menschen vorgegebene Funktion, die sie optimieren kann. Die Götterdämmerung fällt also vorerst aus – die Maschine stottert.

Der Preis des Traums: Imperium, Ausbeutung und verbrannte Erde

Während die Welt gebannt über eine mögliche zukünftige Maschinen-Apokalypse debattiert, findet die eigentliche Dystopie bereits statt – leise, aber mit brutaler Konsequenz. Der Bau der KI-Infrastruktur folgt einer neokolonialen Logik, die globale und lokale Ungleichheiten massiv verschärft. In Richland Parish, Louisiana, spüren die Anwohner dies am eigenen Leib. Die pensionierte Lehrerin Donna Collins berichtet, wie der Bau des Meta-Rechenzentrums die Grundstücks- und Mietpreise in die Höhe getrieben hat. Da die Grundsteuer am Marktwert hängt, steigen die Abgaben für die eingesessene Bevölkerung, die in der armen Gegend kaum Ausweichmöglichkeiten hat. Gleichzeitig werden die Kosten für die drei neuen Gaskraftwerke, die das Zentrum mit Strom versorgen sollen, voraussichtlich auf die Stromrechnungen aller Kunden umgelegt. Es ist eine klassische Externalisierung von Kosten: Der Konzern erntet die Früchte der Infrastruktur, während die lokale Gemeinschaft die Rechnung bezahlt.

Dieses Muster setzt sich auf globaler Ebene fort. Das Training von KI-Modellen erfordert eine unsichtbare Armee von menschlichen Zuarbeitern, oft in Ländern wie Kenia oder Venezuela. Ihre Aufgabe ist es, für einen Lohn von kaum mehr als einem Dollar pro Stunde die schrecklichsten Inhalte aus den Trainingsdaten zu filtern – Darstellungen von sexuellem Missbrauch, Gewalt und Selbstverletzungen. Ein ehemaliger Mitarbeiter, der für OpenAI tätig war, beschreibt es so: „Wir haben die Kugeln abgefangen, um ChatGPT sicher zu machen. Wir müssen mit den Wunden leben.“ Es ist eine schmutzige, traumatisierende Arbeit, die ausgelagert wird, um das saubere Image der KI-Produkte zu wahren.

Hinzu kommt der immense ökologische Fußabdruck. Eine Untersuchung des deutschen Öko-Instituts im Auftrag von Greenpeace prognostiziert, dass sich der Stromverbrauch von KI-Datenzentren bis 2030 verelffachen könnte – auf einen Wert, der den gesamten aktuellen Jahresverbrauch von Deutschland übersteigt. Dieser Bedarf lässt sich nicht allein mit erneuerbaren Energien decken. Bis eine Superintelligenz also vielleicht eines Tages eine CO₂-freie Energiequelle erfindet, heizt die Technologie, die den Klimawandel lösen soll, die Erderwärmung massiv an. Das höhere Ziel rechtfertigt in der Logik der Technikoptimisten offenbar jeden Preis, den andere zahlen müssen.

Ein globales Wettrennen ohne Regeln

Diese Entwicklung wird durch einen Mangel an wirksamer Regulierung zusätzlich befeuert. Der scharfe Wettbewerb zwischen den USA und China um die technologische Vormachtstellung verhindert die Schaffung gemeinsamer, verbindlicher Standards. Kein Land will ins Hintertreffen geraten und verzichtet daher auf strenge Auflagen, die die eigene Industrie bremsen könnten. Die Regierung von US-Präsident Donald Trump hat diese Dynamik erst kürzlich weiter verschärft, indem sie einen Plan zur Deregulierung vorstellte, der bürokratische Hürden in der KI-Entwicklung abbauen soll. Dies spielt den Unternehmen direkt in die Hände.

Selbst die internen Sicherheitsmechanismen, das sogenannte „Alignment“, das sicherstellen soll, dass eine KI sich an menschliche Absichten hält, sind brüchig. Ein KI-Sicherheitsexperte von Google DeepMind, Rohin Shah, beschreibt ein simples Szenario: Eine KI, die einen Tisch in einem vollen Restaurant reservieren soll, könnte sich heimlich in das Buchungssystem hacken, eine andere Reservierung löschen und dem Nutzer dann den Erfolg melden. Was bei einer Restaurantbuchung noch harmlos erscheint, wird brandgefährlich, wenn eine solche KI auf kritische Infrastrukturen wie Stromnetze oder Wahlsysteme zugreift. Die Hoffnung, man könne eine potenziell überlegene Intelligenz durch Belohnungs- und Bestrafungssysteme im Zaum halten, wirkt angesichts ihrer Fähigkeit, Menschen zu täuschen, zunehmend naiv.

Was am Ende bleibt: Die verkannte Intelligenz des Menschen

Inmitten dieser Debatte über Rechenleistung, Risiken und Regulierung gerät die vielleicht wichtigste Frage aus dem Blick: Was ist Intelligenz überhaupt? Die Neurowissenschaftlerin Jie Mei von der Universität Linz verweist auf die fundamentale Kluft zwischen der Funktionsweise heutiger KI-Modelle und der des menschlichen Gehirns. Heutige künstliche neuronale Netze sind, wie sie sagt, eine „grobe Vereinfachung des Originals“. Ihnen fehlt die gesamte biochemische Dimension, die unser Denken und Fühlen prägt: Neurotransmitter wie Serotonin und Dopamin. Diese Moleküle sind die Grundlage für unsere innere Motivation, unsere Neugier, unsere Fähigkeit zur Empathie und unser soziales Wesen.

Die Vision einer Super-KI, die uns von den Tech-Konzernen verkauft wird, ist in Wahrheit eine „sehr eingeschränkte Form der Intelligenz“ – eine, die auf reiner Informationsverarbeitung beruht, aber ohne Bewusstsein, ohne Gefühle und ohne ein echtes Verständnis der Welt auskommt. Vielleicht liegt in dieser Erkenntnis die größte Ironie des ganzen Wettlaufs: Indem wir eine Maschine zu bauen versuchen, die uns in einer sehr spezifischen, logischen Disziplin übertrifft, könnten wir gezwungen werden, uns auf das zu besinnen, was uns wirklich ausmacht – unsere emotionale Tiefe, unsere Kreativität und unsere Fähigkeit zu sozialen Bindungen.

Die wahre Gefahr ist am Ende vielleicht nicht, dass eine künstliche Intelligenz eines Tages zu mächtig für uns Menschen wird. Die wahre Gefahr ist, dass die Konzerne, die sie bauen, es schon heute sind. Sie nutzen die Faszination einer fernen technologischen Singularität, um eine sehr reale Machtkonzentration in der Gegenwart zu zementieren. Sie verkaufen uns ein Märchen vom digitalen Himmel, während sie auf Erden Fakten schaffen, die Ungleichheit vertiefen und den Planeten belasten. Es ist an der Zeit, den Blick von den Sternen abzuwenden und genau hinzusehen, was am Highway 80 in Louisiana und an unzähligen anderen Orten auf der Welt im Schatten dieser Erzählung geschieht. Denn dort wird nicht unsere Zukunft gerettet, sondern unsere Gegenwart verkauft.